SEO-Константа

Яндекс.Директ + оптимизация

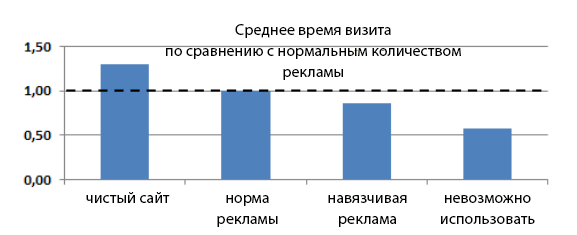

Поисковый спам негативно воздействует на качество поиска и впечатление пользователей, а так же заставляет поисковые системы тратить ресурсы на сканирование, индексирование и ранжирование бесполезных документов. Таким образом, поисковым системам приходится вести постоянную борьбу со спамерами. Трафик из поисковых систем играет важную роль в онлайн-экономике. Поэтому создаётся серьёзная конкуренция и высокие позиции в поисковых результатах побуждают спамеров разрабатывать новые технологии мошенничества. В то же время алгоритмы ранжирования становятся более сложными, наряду с развивающимися технологиями детекции спама. Так как спам постоянно эволюционирует, задача детекции спама всегда остаётся первостепенной. Самая популярная поисковая система России Яндекс обладает определённым опытом по борьбе со спамом. В данной работе описывается наш опыт по детекции различных видов спама на основе содержания, ссылок, кликов и пользовательского поведения. Мы так же рассматриваем навязчивую рекламу и мошенничество, так как они влияют на пользовательское впечатление. Кроме того, мы демонстрируем связь между классическим поисковым спамом и современными методами социальной инженерии, применяемых в мошеннических технологиях.

Так как поисковые системы используют содержимое страницы в качестве фундамента ранжирования, контентный спам стал одни из самых распространённых видов спама. Спамеры пытаются повлиять на такие факторы ранжирования, как TF/IDF или BM25 посредством создания текстов (зачастую, бессмысленных) с оптимальной частотой ключевых фраз. Детекция такого вида спама разрешается при помощи подходов на основе языковой модели [4], [8].

С тех пор, как поисковые системы начали использовать ссылочное ранжирование (такое как PageRank), спамеры начали воздействовать на эти факторы через линкофермы, непотистские ссылки, проплаченные ссылки и прочие искусственные методы формирования ссылочной массы. Большинство подходов по детекции ссылочного спама основаны на свойствах веб-графов [1], [11]. Использование информации о поведении для ранжирования ресурсов провоцирует применение соответствующих спамерских технологий, таких как кликовое мошенничество. Существует несколько технологий по детекции спама на основе пользовательского поведения [6], [9].

По нашему опыту известно, что любой фактор, учитываемый в ранжировании может быть использован для получения более высоких позиций в выдаче поисковой системы. Спамеры сильно мотивированы к поиску и использованию подобных характеристик. Поэтому поисковые системы должны всегда учитывать подобные настроения при разработке и введению в эксплуатацию новых характеристик и алгоритмов ранжирования.

Обман на основе факторов ранжирования является не только спамерской целью для заработка. С целью повышения монетизации трафика, многие спамеры обманывают не только поисковые системы, но и самих пользователей, поэтому поисковым системам следует учитывать и этот фактор. Социальный аспект борьбы со спамом не менее важен, чем технический.

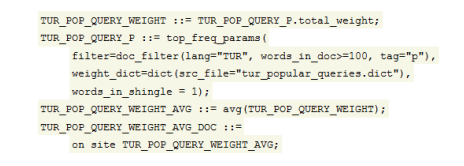

Существует огромное число страниц в Интернете, поэтому поисковые системы должны обрабатывать документы действительно быстро. В поисковом индексе Яндекса содержится более 20 млрд документов и более 3 млрд документов сканируется ежедневно. Некоторые из них приходится обрабатывать специальным взаимодействием с интерпретацией JavaScript и отображением полного содержания. Мы разработали и ввели в эксплуатацию специальный язык на основе регулярных выражений для создания различных классификаторов контента. Этот язык используется в быстрой системе классификации, которая способна обрабатывать до 200000 документов в секунду. Несколько классификаторов с высокими характеристиками точности и полноты были разработаны специально на основе этой технологии. Классификаторы контента основываются на правилах, которые можно легко написать даже без специальных навыков программирования (см. Рисунок 1).

Рисунок 1. TUR_POP_QUERY_WEIGHT_AVG_DOC — характеристика документа «средний вес в словаре популярных турецких запросов».

Эти правила служат в качестве слабых классификаторов, результат работы которых потом подаётся в виде характеристик в алгоритмы детекции поискового спама на основе градиентных древ решений [5]. Существует множество данных о доменах, тексте, ссылках, кликах, пользовательском поведении и т.д., которые используются для разработки характеристик. Помимо использования постоянно обновляющегося набора размеченных профессиональными ассессорами данных, наш алгоритм обучается на обратной связи, ежедневно получаемой технической поддержкой. Данная обратная связь позволяет вовремя отслеживать новые тенденции в спамовых технологиях и прочие виды мошенничества.

Главной целью поискового спама является привлечение трафика из поисковых систем. Спамеры учитывают различные факторы наподобие популярности запросов, уровня конкурентности, используемой функции ранжирования для различных запросов и т.д. Стоит упомянуть, что поисковый спам стоит очень близко к поисковой оптимизации (SEO). Конечно же, есть законопослушные SEO-практики (белая оптимизация), когда веб-сайт анализируется на наличие технических проблем. К сожалению, прочие SEO-техники используются для агрессивного продвижения сайтов в поисковых результатах по данному набору запросов (серое и чёрное SEO). В основном есть 4 главных аспекта продвижения: текстовое содержание, домены, ссылки и пользовательское поведение. Каждый аспект соответствует группе характеристик ранжирования. Чёрные и серое SEO манипулирует характеристиками для получения максимальных позиций в поисковой выдаче.

Типичная «оптимизация» основывается на обмане TF/IDF и состоит из экспериментов с ключевыми фразами, их частотой и размещением в тексте методом проб и ошибок. Такой способ искусственного размещения ключевых фраз в тексте чаще всего ухудшает качество страницы и существенно расстраивает пользователей. Поэтому чрезмерная оптимизация текста должна контролироваться поисковыми системами, а характеристики текстового ранжирования требуют аккуратной настройки.

Эффект большого веса доменных характеристик показан ниже. Простейшим способом является использование доменного имени, которое содержит слова из продвигаемой ключевой фразы. Это может показаться странным, но использование данного метода для получения коммерческой выгоды легко приводит все результаты по специфическому запросу на такой сайт (каждый домен в поисковой выдаче содержит подстроку из запроса).

Рисунок 2. Спамовые доменные имена в 2010 году. Показана процентная доля доменов в TOP-10 по 10 тысячам запросов, в которые включены триграмы запросов.

Покупка ссылок в специализированных сервисах является одной из самых популярных методик ссылочного спама в России. К сожалению, эта практика сильно распространена из-за задержки реакции поисковых систем. В относительно долгом периоде проплаченные ссылки были эффективным методом для продвижения сайтов и были повсеместно распространены. Это продемонстрировало, что поисковые системы должны очень быстро реагировать на новые спамерские техники. Мы считаем, что быстрая реакция поисковой системы на новые типы спама важнее, чем полнота выдачи алгоритма.

Мы разработали эффективный алгоритм, который комбинирует категоризацию анкорного текста и анализ графов для детекции проплаченных ссылок [7]. Классификатор проплаченных ссылок помогает рассчитывать факторы релевантности для коммерческих и некоммерческих запросов по-разному. Это позволяет улучшить алгоритм ранжирования для повышения качества поисковой выдачи, понизить влияние SEO на некоммерческие запросы и разнообразить результаты запросов. Важно отметить, что проплаченные ссылки легко классифицируются поисковыми системами, что позволяет легко осуществлять контроль над качеством поиска и бороться со спамом, нацеленным на коммерческие запросы. Но так же стоит сказать и то, что покупка ссылок является отличительной особенностью русского сегмента Веба, в основном, из-за низкой скорости реакции.

Как следствие, в середине 2007 все популярные поисковые системы в России были под сильным влиянием SEO. Было очень легко продвигать сайты в топ-10 в те дни. Алгоритмы ранжирования не были защищены от подобных систем мошенничества и поэтому множество обычных запросов были подвержены ссылочному спаму. К примеру, 8 из 10 результатов по запросу «вода» содержали предложения по доставку воды, а 9 из 10 результатов по запросу «насекомые» описывали вымирание насекомых. Таким образом, многие некоммерческие поисковые запросы были заспамлены с целью монетизации, что сильно повлияло на качество и разнообразие выдачи. За последующие годы поисковые системы улучшили свои алгоритмы и усложнили задачу продвижения сайтов, при это сильно разнообразив поисковые результаты.

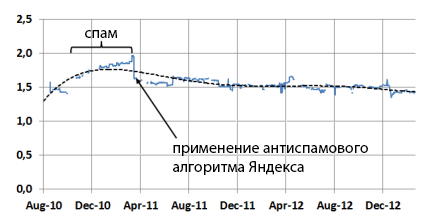

Так как пользовательское поведение является хорошим источником для ранжирования [2], спамеры начали свои исследования по поиску уязвимостей в данном факторе. Они не знали, как рассчитываются кликовые характеристики, но справедливо заключили, что CTR (click-through rate) играет важную роль. Самой обычной техникой являлся поиск вебсайта в поисковой выдаче и клик по его ссылке. Дальнейшее развитие этой техники привело к созданию сообществ с покликовой оплатой, где дешёвые наёмники подавали специализированные запросы в поисковую систему и кликали по необходимой ссылке в соответствии с выданными инструкциями. Ситуация усугубилась, когда подобные действия начали выполнять ботнеты. Кликовое мошенничество является одним из самых негативных методов продвижения сайта, очень сильно влияющая на всю экосистему Интернета. Поэтому поисковые системы стараются как можно быстрее определять любое кликовое мошенничество и устранять его. С целью понижения влияния SEO на качество поиска Янекс штрафует веб-сайты, которые пытаются обманывать систему посредством кликового мошенничества и ограничивает влияние кликовых характеристик на ранжирование по коммерческим запросам.

Рисунок 3. Доля коммерческих запросов в топе выдачи уменьшилась, разнообразие поисковых результатов по транзакционным запросам существенно увеличилось.

Как видно, существует несколько «векторов атаки», которые следует учитывать поисковым системам. Соответтвующие классификаторы и ограничения разрабатываются в Яндексе для минимизации эффективности этих атак. По причине активного противодействия со стороны поисковых систем, спамеры постоянно ищут новые методики обмана. Так как поисковые системы разрабатывают эффективные алгоритмы анализа содержимого, ссылок и кликов, спамеры направляются в те зоны, которые ещё мало изучены специалистами по информационному поиску — например, спаминг динамического контента. JavaScript и ActionScript позволяют добавлять практически любые данные на страницу. Индексирование HTML обычно не выдаёт поисковым системам информацию о том, как выглядит веб-страница после интерпретации JavaScript-кода. Таким образом становится возможной разработка новых методов поискового спама, которые сложно определить.

Качество поисковых результатов является самой важной характеристикой для поисковой системы и она напрямую влияет на её популярность. Существует много методов проверки качества поисковых систем [3]. Методы качественного анализа, основанные на автоматическом анализе взаимодействия пользователя с поисковой системы (логи пользователей) являются весьма важными для транзакционным запросов. Однако ручная проверка транзакционных запросов намного сложнее, требует больше времени и, как следствие, стоит дороже.

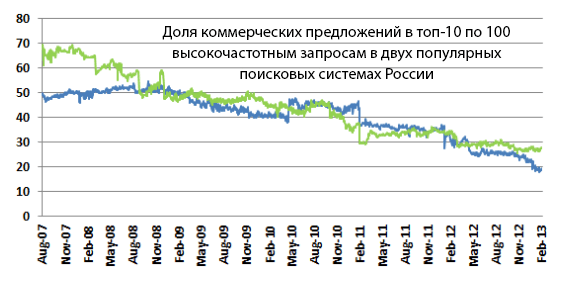

Одинаковый медийный контент, файлы и софт могут дублироваться на различных сайтах. И хотя существует множество релевантных страниц, которые позволяют пользователю скачивать файлы или просматривать видео, которое он ищет, не все страницы одинаково нравятся пользователю. К примеру, развлекательный веб-сайт, который создаёт интересный контент, может размещать рекламу для создания коммерческой выгоды. Однако жадность может побудить к использованию повышенного количества рекламы и тогда веб-сайт станет весьма недружественнен к пользователю или понизится его юзабилити, так как необходимый контент будет попросту недоступен. В нашем исследовании влияния рекламы на пользовательское впечатление мы использовали характеристику «продолжительности визита» (dwell time) — известную [2] характеристику, которая позволяет оценить удовлетворение страницей пользователя. Мы попросили экспертом оценить 53200 URL и собрали 93900 оценок. Было 4 типа оценки: страница без рекламы, страница с приемлемым количеством рекламы, страница, которую «невозможно использовать» и спам (102 спам URL были исключены, 2107 страниц с ошибкой 404 так же были исключены). 370 вебсайтов из 16000 (2.3%) содержали страницы, которые «невозможно использовать». Результаты измерений показаны на рисунке 4.

Рисунок 4. Средняя продолжительность посещения зависит от объёма рекламы на вебсайте.

Видно, что сайты с невменяемым количеством рекламы отпугивают пользователей и провоцируют жалобы. Средняя продолжительность визита для мусорных сайтов в 1.7 раза ниже, чем для нормальных. Важно отметить, что такая разница в продолжительности визита напрямую влияет на популярность сайта. Разница между средней продолжительностью визита нормальных и мусорных сайтов уменьшается с ростом популярности. Это означает, что вебмастера более трепетно относятся к реакции своих пользователей, если их сайт известен в Интернете.

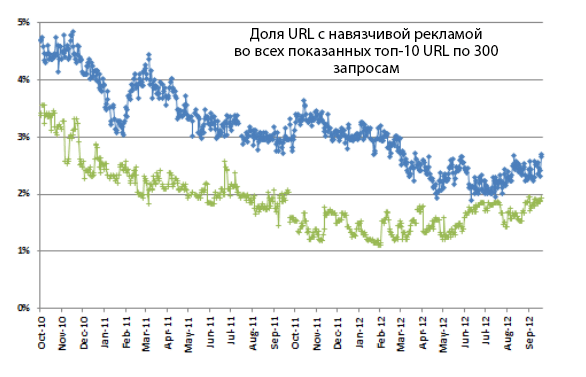

В Яндексе используется алгоритм, который определяет наличие навязчивой рекламы, а так же алгоритм оптимизации средней продолжительности визита. Алгоритм выбирает веб-страницу без навязчивой рекламы из нескольких результатов с похожим контентом и отдаёт ей предпочтение. Его использование приводит к более высокому уровню удовлетворения пользователей по транзакционным запросам. Такая стратегия вынуждает веб-мастеров либо накапливать трафик из поисковых систем, либо продолжать использование рекламы. Тогда вариант развития событий по сценарию «сделать множество дешёвых веб-сайтов с пиратским контентом и агрессивной рекламой» (дорвеев) уже не работает. Поэтому количество агрессивно монетизированных ресурсов существенно снизилось, несмотря на попытки некоторых вебмастеров скрывать рекламу от поисковых систем при помощи обфускации (сокрытия) HTML-кода (см. рисунок 5).

Рисунок 5. Количество сайтов с навязчивой рекламой в русском сегменте Веба уменьшилось в два раза за последние два года.

Как видно, поисковые системы способны обнаруживать навязчивую рекламу в динамическом контенте. Это свойство существенно уменьшает трафик, получаемый мошенниками из поисковой системы. Поэтому спамеры встречаются с проблемй оптимизации: как увеличить эффективность баннера? Использование навыков социальной инженерии и вредоносных программ становится новым шагом в эволюции поискового спама.

Сервисы микроплатежей (посредством СМС) являются основой для теневой экономики в российском Интернете. К примеру, целевые страницы с платной мобильной подпиской являются самыми выгодными коммерчески для получения финансов через чёрное SEO [10]. Чёрные сеошники создают специальные схемы воздействия, когда вычислить получателя денег очень нелегко: у мобильного оператора есть несколько крупных партнёров (контентных и сервисных провайдеров), у этих партнёров есть свои партнёры и т.д. Неважно, как именно организовано получение денег, если пользователь подтверждает платную подписку или отправляет платное СМС. В большинстве случаев чёрный трафик идёт по неясному или вообще не показанному пользователю соглашению. Широко применяется социальная инженерия для увеличения количества подписок. Неопытные пользователи больше доверяют знакомым сайтам и брэндам, поэтому спамеры зачастую пользуются их наивностью. Например, некоторые мошеннические сайты включают JavaScript-код, который отображает ложное сообщение из социальных сетей, а по клику выполняют вредоносный скрипт.

Клик ведёт по ложному сообщению ведёт на специальные страницы с формами подписки. Такие формы зачастую показываются как всплывающие баннеры на страницах авторитетных сайтов. К примеру, ложное сообщение может содержать информацию о лотерее со стороны Яндекса и гарантировать призы, после чего пользователю будет предложено оформить мобильную подписку. Так же используются разнообразные методики фишинга. Весь контент подгружается динамически с использованием JavaScript-кода, который обычно обфусцируется. Другие типы страниц используют вредносный софт. В основном существует два подхода к атаке пользователя в Сети: загрузка вредоносного кода или социальная инженерия. Первый способ использует уязвимости в браузерах, плагинах или аддонах. В этом случае заражение чаще всего не обнаруживается. Во втором случае используется страх, жадность или неопытность пользователя. Ему может быть предложено скачивание популярного софта бесплатно или «предупреждение о безопасности» с целью обязательного обновления браузера (этот подход похож на обманный «антивирусный софт» [12]). Так или иначе спамеры получают возможно изменять настройки системы пользователя, вносить изменения в файлы и т.д. На данный момент наблюдается широкая активность по фармингу, когда файл hosts модифицируется для подмены IP-адресов популярных вебсайтов. Следует заметить, что любая подмена чаще всего ведёт на монетизируемые СМС-подписки или рассылки. Доля успешных атак здесь выше, так как визуально для пользователя ничего не меняется. Популярный веб-сайт подменяется ложным, однако даже в адресной строке остаётся прежний адрес сайта.

Современные SEO и спам-техники развиваются технически. Соответственно, требуются продвинутые способы борьбы со стороны поисковых систем. Системы обнаружения спама следует модифицировать с учётом широкого использования JavaScript. Требуются дополнительные ресурсы на интерпретацию JavaScript-кода и поиска соответствующих особенностей. Поисковый спам имеет тенденцию работать в паре с мошенничеством, так как широко использует взломанные сайты, вредоносный код, ботнеты, фишинг и фарминг. Так же широко применяются техники социальной инженерии, что заставляет поисковые системы уделять внимание образовательным проектам и сервисам. Тем не менее, поисковые системы по-прежнему обладают сильным влиянием на Веб и продолжают успешно бороться со спамом, уменьшая количество случаев мошенничества.

Авторы благодарят Сергея Пименова и Павла Сердюкова (Яндекс) за их ценную помощь.

Полезная информация по продвижению сайтов:

Перейти ко всей информации